SOFTMAX函数的脉络梳理

2022-05-08SOFTMAX回归模型

什么是SOFTMAX回归函数

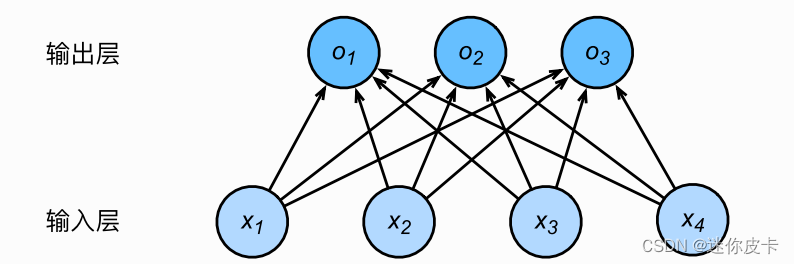

·softmax回归跟线性回归⼀样将输⼊特征与权᯿做线性叠加

·与线性回归的⼀个主要不同在于,softmax回归的输出值个数等于标签⾥的类别数

·SOFTMAX是一个单层的神经网络

结构图如下:

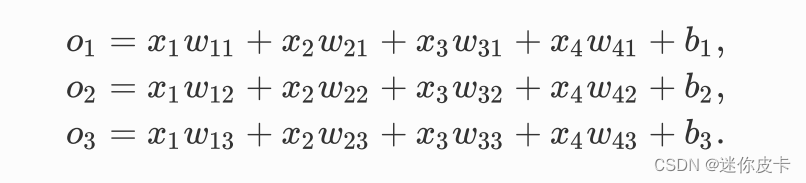

运算过程如下:

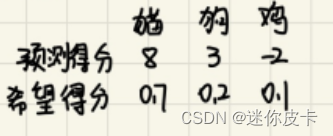

即我们通过神经网络预测,然后得到相应的一个分数,此时我们希望我们得到的分数是一个概率:

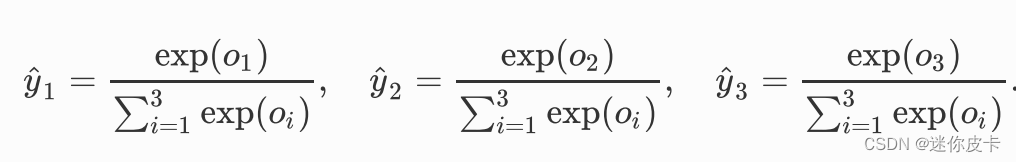

此时我们就应该选取一个合适的方案,来将预测的分数来转化为标签的概率,那么最合适的肯定是softmax了,softmax公式:

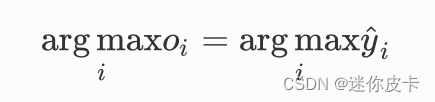

即将得到的分数都进行exp,然后求每个标签占比(概率),最终我们得到的是预测概率最大的标签:

很显然,我们只关注预测概率最大的标签(单标签预测)

总结了一下特性:

·结果都为正数:即将得分为负数的进行转化

·所有求和为1:所有概率相加等于1

·平移不变性:所有得分平移得到的结果不受影响

·最大–>最大:预测得分最大的概率也大

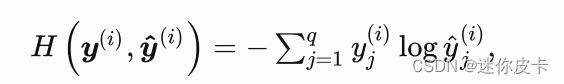

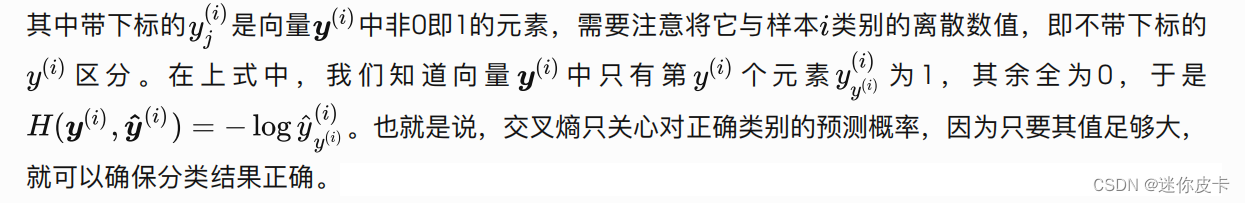

交叉熵损失函数

在这里我们使用的是交叉熵损失函数(Cross Entropy)

实现代码:

·导入包:

1 | import torch |

若出现没有‘d2lzh_pytorch’这个包,点击此处离线安装

·导入数据:

1 | batch_size = 256 |

·定义网络:

1 | num_inputs = 784 |

·初始化模型参数:

1 | init.normal_(net.linear.weight, mean=0, std=0.01) |

·定义损失函数和优化器:

1 | loss = nn.CrossEntropyLoss() |

·训练:

1 | num_epochs = 5 |